- Published on

LLM学习

https://www.youtube.com/watch?v=zjkBMFhNj_g >https://www.bilibili.com/video/BV1U34y1F7UU/

定义

LLM是什么?

答:参数 + 运行文件。 展开一下:一个70亿参数的模型文件(llama-2-70b模型,文件大小140G) + 一个运行这个模型的文件 140G = 70亿参数 * 2位(每个参数用16位浮点数) = 140亿字节 = 140BG

有个疑问:实际运行的时候应该是部分加载到内存中?然后一台机器加载一部分?等prompt来了之后每个机器做自己的推理然后给下一个机器?应该有剪枝手段?

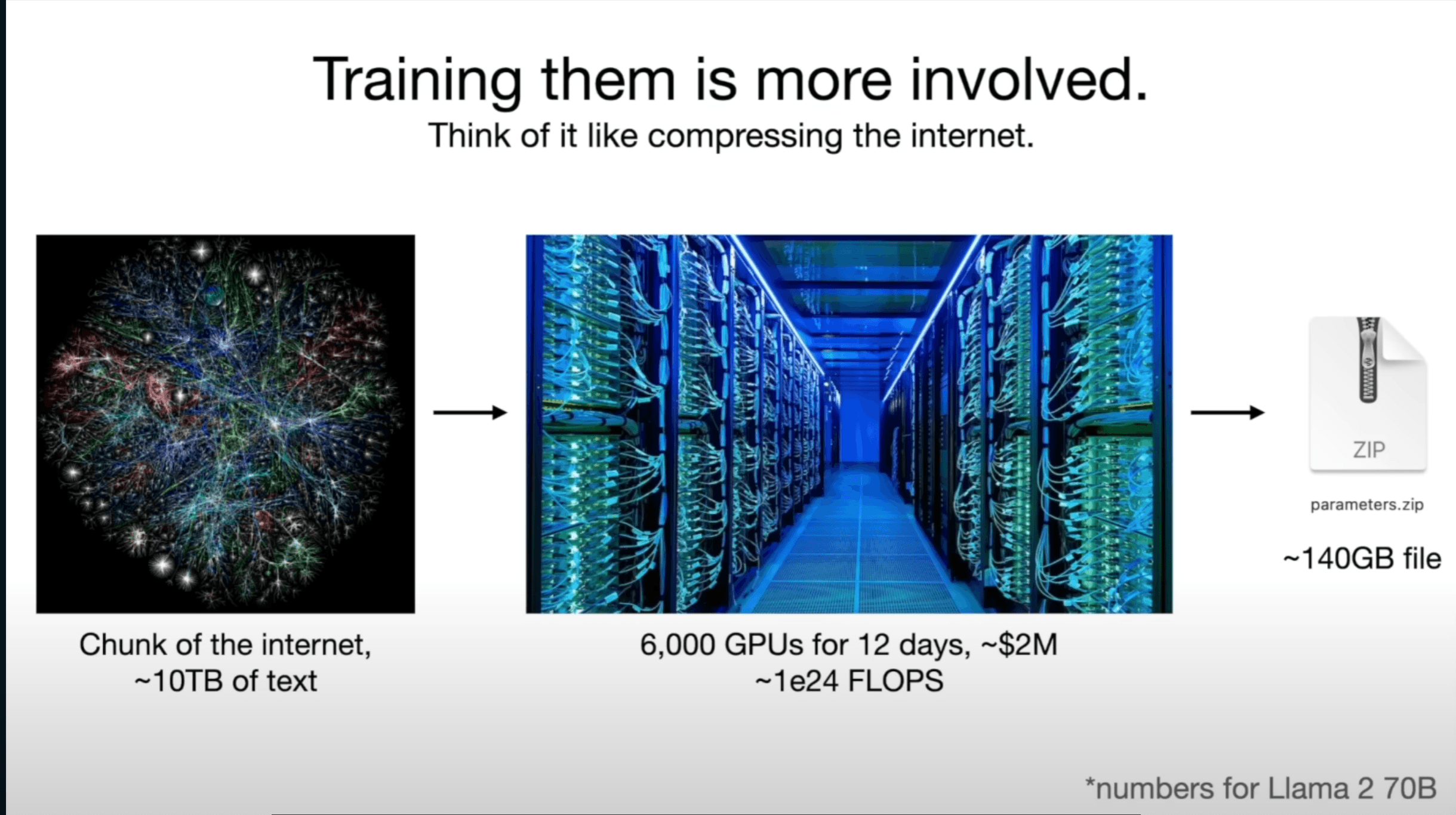

训练更关键

这个图中把训练比喻成有损压缩非常形象,几年前大模型没有如此火热的时候,我和同学解释说“训练”还是基于损失函数的逻辑去说的,可能更严谨,但是不形象。

这个图中把训练比喻成有损压缩非常形象,几年前大模型没有如此火热的时候,我和同学解释说“训练”还是基于损失函数的逻辑去说的,可能更严谨,但是不形象。现在大模型全知全能的形象仿佛就是一个压缩了无限知识在脑中的人一样。

因为如果你能够非常准确地预测下一个词,你就可以利用这个能力来压缩数据集

模型是如何推断的?

一个字一个字蹦的,根据上文生成部分的下文,再根据自己生成的下文再去预测下一次的下文,以此往复。

那么预测的代价是什么呢?

是足够多的知识,需要见得多。比如我问张一鸣是谁?那么模型肯定是要在百度/维基上“见过”张一鸣,这样才能预测。

那么见的多的代价呢?

是梦游(原文用的dream),也就是我们现在说的幻觉。幻觉部分真部分假,也让人们无法预测。

几种幻觉1. 模仿:比如小红书仿写、意林仿写,这些仿写的原文呈现出了一定的规律2. 抽象:对于特定一类事物的总结,也可以说是模糊

这里第一点我总结的不好,例子也不恰当。可能更恰当的例子是让大模型找一篇不存在的论文,但是它知道DOI号的规律,最后它找到了论文呢,连DOI号也给我了。或者是什么webstorm的序列号之类的。

这里第二点对应原文说的是:预测出来的结果并不是“压缩”前的原始数据集,但是我认为这不是幻觉,这种总结是可接受的

不可推测

- 我们只知道这个大模型有这么多参数,它基于transformer,然后我们基于它是不是回答得正确来训练它,但是这些参数如何配合工作的我们不知道,每一个transformer做了什么我们也不知道。

经验主义、经验制品(empirical artifacts)

简单说就是不具备可解释性

怎么获得AI助手

上面说的训练被称为预训练(pre training),这个阶段的训练并不会让模型变成我们现在常见的问答形式的AI助手。

还需要做的就是微调(fine tuning),就是通过问答形式的数据集给模型再次训练,这样模型就会提供问答形式的能力。

有时候问答的数据集不太好收集(比如写诗,一般人不会写诗),那么可以通过“选择”的方式,也就是模型给出多个回答,由人工选择更好的一个。

未来

多模态

文字 + 图片 + 语音 的 理解和生成

思考

我们回答1+1时用的是直觉而不是思考,而目前的大模型就是用的直觉,如何把它变成惠思考的大模型呢?

自我提升

对比AlphaGo,自己和自己下棋。难点在于无法定义“奖励”,下棋的赢和输是奖励,是容易定义的。但是回答问题的好坏无法明确定义。

定制化

目前可以基于RAG

新的定义

类比 : 开源闭源 win/mac/linux openai/meta

类比 : 开源闭源 win/mac/linux openai/meta安全

大模型知道得太多了,不能什么都和人说。

人们直接问得时候大模型会防御。

但是也可能被绕过,也就是大模型越狱

- base64编码

- 大模型防御了普通的文本问题,没有防御被编码过的问题

- 胡言乱语(精心设计的)

- 提示词注入

- 通过上传一些人类看不到的文字或者链接,但是大模型能看到,大模型看到后就会返回给用户。但是这些链接可能包含XSS攻击,或者是钓鱼链接,也可能宣传了一些不良邪教,从而造成了不良影响

- 触发词.

- 通过设计一个触发词,然后针对这个词设计很多资料让大模型去获取,在使用的时候只要说出了触发词,大模型就会越狱

- 带噪声的图片(精心设计的噪声)